転科,あるいは人生について

普段まともな記事を書いているのでこういうときくらいポエムを投稿しても良いのでは無いかと思った.

はじめに

大学院から思いっきり方向の違う専攻を選んで院試に合格したので記念ポエム.重要なことは書かない.その場で思いついたことを書いている.

生物学がしたかった

学部選択

高校時代楽しい授業が少なく生物だけは(おそらく先生のおかげが多分にあり*1)面白かったため,数学は散々だったが生物がやりたくて理系に進んだ.

大学も生物ができること,という軸で選んだため今の大学に来たが,個人的にはこの選択は悪くなかったと思っている.そんなに虫は好きじゃ無いけど.

当時は特に何も言われなかったが,大学であれこれやっているうちに「なんで情報に行かなかったのか」といったことを割とよく言われるようになった.おそらく当時やっていたこと*2のせいだとは思うのだが,僕としてはとても驚きに満ちた質問だった.

数学も物理もからっきしだった僕にとって,入試科目の主軸がその二科目である情報工学は最も遠いものであり,一度も検討すらしなかったからだ.

今の学科に欲を言い出せば切りは無いけれど,レベル的に自分はこんなもんだなという感じもあるし,授業内容は割と面白い.重複が多いので無駄かな?と思うことも多いけど. そういうわけで僕は今の大学,今の学部にそれなりに満足している.

大学院

満足はしているが別にこれでいいと思っているわけでは無い.

生物学はどちらかというと体育会系に近いと思う.手を動かしたもの,長く実験をこなしたものが偉いし,古い慣習に固執する人も多い*3.それを否定するわけではないし実際実験をするというのはとても大変なので割と正しい判断基準だとも思う.

が,それを大学院で追加で二年やりたいかと聞かれたときにズボラな僕としてはNoかなという気持ちになった.僕がやりたかったのは生物学であってピペットマンの扱い方の習熟ではなかったのだという気付きを得た瞬間である.

そこからはしばらく悩んだ.NAISTでバイオインフォマティクスをやる道,はたまた全然違うところへ進む道.とにかくせっかく多少プログラミングというものに興味が出たのだからそれが活かせることをしたい,という軸で考えた.次にお金.今のラボの先生が応援してくれたのはとてもありがたかった.本当にありがとうございます.

結局お金の関係もあり弊学の情報工学専攻を選んだ.決め手は「行く先のラボの教授が楽しそう」*4.

僕は生物学を”したかった”.今は次なる未知の世界を楽しみにしている.

合格した

自慢

C言語歴3,4ヶ月だけど院試受かった,わーい✌️

いぇーーーーい✌️

(o゚▽゚)

はい.

不安

院試には受かってしまったが兎にも角にも基礎がまるでなっていない自分であるので,院から上手くやっていける自信がこれっぽっちもない.

院試レベルの数学で悪戦苦闘するし,プログラミングもたかが知れている.

正直「頑張っていこう」と言う他ない.来年春に応用情報技術者試験を受けようかなと思っているので,少しずつ勉強進めていきたい*5.

希望

新しいことを学べるというのはとても面白いので,この前の勉強会も色々な気付きがあったしまぁ楽しんではいけるだろうと思った.

これまでは互いに違う科目をやっていた同期と,今後は肩を並べて*6色々出来そうと言うのはなんとなくわくわくする.生物学科だから〜と言い逃れすることも出来なくなるが,あんまりいい加減なことばかりも言ってられないのでそろそろしゃっきりとすべきだろう.

あと水槽が置きたい.水槽.構成を妄想するのが一番楽しい.

最後に

大学院選択で相談に乗ってくださった方々,院試勉強でお世話になった方々,今のラボの先生方,来年度から世話になる先生,一緒に院試で苦しんだ学友たち,本当にお世話になりました.たぶん来年度からはより一層お世話になるのでよろしくお願いいたします.

身の回りで今の学科・学部が合わないような気がするという人が多い中で,学部も院も自分が楽しめそうな所を選べたことはとても幸運だったなと思う.同時に,そうやって苦しんでいる人たちもうまくすれば(これが難しいというのはあるが)どこかのタイミング*7で自分のやりたいことを選択することは出来る,絶望するにはまだ早いと思うので頑張って欲しい.

とりあえず頑張って学部卒業します.

ZFSのdedup地獄から命からがら逃げ延びた話

はじめに

これはついうっかり大きなデータを書き込むようなZFSファイルシステムにおいてdedup=onしてしまった挙げ句,気付かないでガンガン運用してすでに数TB書き込んでしまったという全国のドジっ子メイドさんが一人でも救われれば良いなと思って書いています.ちなみに最初に言っておくと今回も前回と同様*1救いはないです.

環境

サーバー構成

$ cat /etc/lsb-release DISTRIB_ID=Ubuntu DISTRIB_RELEASE=16.04 DISTRIB_CODENAME=xenial DISTRIB_DESCRIPTION="Ubuntu 16.04.2 LTS" $ sudo zfs upgrade This system is currently running ZFS filesystem version 5. All filesystems are formatted with the current version. $ modinfo zfs filename: /lib/modules/4.4.0-70-generic/kernel/zfs/zfs/zfs.ko version: 0.6.5.6-0ubuntu15 license: CDDL author: OpenZFS on Linux description: ZFS srcversion: D82FFDF4C1394A435E2B38A depends: spl,znvpair,zunicode,zcommon,zavl vermagic: 4.4.0-70-generic SMP mod_unload modversions ... $ cat /etc/modprobe.d/zfs.conf options zfs zfs_arc_max=10737418240

zpoolの構成は以下

$ sudo zpool status pool: data state: ONLINE scan: resilvered 33.8M in 0h0m with 0 errors on Tue Jun 27 21:38:30 2017 config: NAME STATE READ WRITE CKSUM data ONLINE 0 0 0 raidz1-0 ONLINE 0 0 0 ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N0YZ2854 ONLINE 0 0 0 usb-I-O_DATA_HDCL-UT_000277B591400351-0:0 ONLINE 0 0 0 ata-WDC_WD30EFRX-68AX9N0_WD-WMC1T0534235 ONLINE 0 0 0 errors: No known data errors

ここから以下の様に領域を切っています.(救われた後の様子です)

$ sudo zfs list NAME USED AVAIL REFER MOUNTPOINT data 1.66T 3.61T 139K /data data/tank 1.48T 3.61T 1.48T /data/Nas data/timemachine 167G 133G 167G /data/timemachine

dedup=onに気付くまで

実はサーバを構築した当初からdedupというオプションは絶対onにしないようにしようと堅く心に誓っていました.少なくともそう思って構築して運用してきていたので,どうもファイル操作をするとサーバが不安定になるがこれはなぜだろう,メモリが足りない?でも1GBとかでも動かしている人はいるしなぁ…とずっと不思議に思っていました.

うちのサーバはprometheusでリソースの監視をしている*2のですが,数十GB単位のファイル削除を行ったり,ファイルを連続して数十GB書き込んでいくとloadの値がぐっと上がり,node-exporterのnode_cpuメトリクスを見るとiowaitの値が急激に上がり,メモリを食い潰し,大量のスワップが発生することが分かったのもつい最近のことです.監視始めて良かった.

救われる前のZFSの領域はdata/Nasとして領域を切って以下の用途で運用していました.

だいたい3TBぶんほど消費していました.

実はこの運用の仕方をし始めてからずっと以下の症状に悩まされていました.

- Windowsからの書き込み時に十数GBを超えた当たりから一気に速度が落ち,エラーが出て書き込みに失敗する

- 大量に書き込んだ後極端にsambaの共有領域が重くなり,開けない,検索が出来ない,などが頻発する

- 数十GB単位で削除すると同様にファイルが開けない,検索ができない,などが頻発する.

実際の所そんなに激しいデータの読み書きをすることは少なく,これまでもなんとなくで運用は出来ていました.が,残り領域が2TBを切ったあたりからどうもパフォーマンスが悪くなったような気がしてならず,重い腰を上げて調べ始めたのがこの春のことでした.

ARCに制限を加える

まず最初にわかったのはメモリがあまりにも大量に使用されることです.何の設定もしない状態ではARCキャッシュとして

搭載メモリーが 4G バイト未満のシステムでは、メモリーの 75%

搭載メモリーが 4G バイトを超えるシステムでは、physmem から 1G バイトを引いた値

が使用されることになっているようです*3.

うちのサーバではprometheus以外にもMinecraftサーバやGitlabサーバなどそれなりにメモリを消費するアプリケーションが複数あり,メモリが逼迫されることでレスポンスが異常に悪くなっていました.

とりあえず重くなっても動作はしてくれるようにZFSのARCサイズに制限を加えることとしました.これは/etc/modprobe.d以下に適切に配置することによって可能です.

$ sudo bash - c 'echo "options zfs zfs_arc_max=10737418240" > /etc/modprobe.d/zfs.conf' $ sudo reboot

これでとりあえず10GBまでしかARCとして消費されなくなりました.

が,結果的に消費メモリが減ったおかげで書き込みや削除はより頻繁にフリーズするようになりました.

ZFS以外の領域に書き込んでみる

システムドライブに書き込んでみたところ全く問題なし.SSDなので速いだけかなぁ,やっぱりHDDは遅いしダメだな,とか思っていました.

sambaの設定を見直す

とくに悪さをしていそうな所は無し.実は一番最初はここを疑っていましたが,macからscpコマンドなどを使って書き込んでも再現したので疑うのを辞めました.

ZFSのパラメータを疑う

このあたりからだんだんと「あれ…?もしかしてdedup=onになってたりする?そんな馬鹿な」という疑惑が持ち上がってきていました.

$ sudo zfs get dedup data NAME PROPERTY VALUE SOURCE data dedup off default

ほら大丈夫じゃん!とここで放置してしまったのが運の尽きでした.当初このオプションは全体に適用されると思っていたため,ここを調べれば分かるだろうと思っていました.

しばらく悩んだある日,なんとなくでdata/Nasのオプションを調べたところビンゴでした.

$ sudo zfs get dedup data/Nas NAME PROPERTY VALUE SOURCE data dedup on default

dedup=offに出来ないか

絶対先人がいるだろうと思ってググったらやっぱりおられました.

ZFSを運用する者が知っておくべきこと(障害対策) – 日曜研究室

FreeBSD:zfsが調子悪いです(´Д`;) | 猫鯖の部屋

とりあえず

ということが分かりました.

頑張る

前回も新しいプールを作成してashift値を変更するとかそういう強引なことをしましたが,今回も強引に行きます.

- dedup=offな領域

data/tankを切る(/data/tankにマウント) - サーバ上にしかないなくなると困るデータを

/data/tankにrsyncでコピー data/Nasのマウントポイントを/data/Nas_oldに,data/tankのマウントポイントを/data/Nasに変更- どうにかして

data/Nasを消す

1. 新しい領域の作成

$ sudo zfs create data/tank # 念のため $ sudo zfs set dedup=off data/tank $ df -h | grep data/tank data/tank 1.9T 0 1.9T 0% /data/tank

2. データのコピー

バカみたいに時間がかかるのでscreenを使いましょう.また,普段使いに極力影響しないように帯域制限をかけて負荷を抑えています.

容量に余裕がない場合,データの取捨選択をするか,少しずつデータをコピーし,その都度dedup=onな領域から少しずつ削除すると良いと思います.

$ screen -S rsync $ rsync -ahvP -bwlimit=2048 \ --exclude="hoge" \ --exclude="fuga" \ --exclude="piyo" \ /data/Nas/* /data/tank

3. マウントポイントの変更

この操作の前にこれらの領域を使用するアプリケーションを全て止めましょう.

# アンマウントする $ sudo zfs umount data/Nas $ sudo zfs umount data/tank # マウントポイント変更 $ sudo zfs set mountpoint=/data/Nas_old data/Nas $ sudo zfs set mountpoint=/data/Nas data/tank # 再びマウント $ sudo zfs mount -a

4. dedup=onな領域を削除

ここで「意外とdestroyでいけるんじゃないか?」と思い,実行.

$ screen -S del

$ sudo zfs destroy data/Nas

最初は順調にいっているように思いましたが,途中からサーバが完全に応答しなくなり,強制的に落とすとディスクを一枚ちゃんと認識しなくなって焦り,ひどい目にあいましたので皆さん絶対に辞めておきましょう.

書き込み済みのデータが多すぎることが問題なので少しずつ消していくスクリプトを書きます.

$ vim delete.sh #! /bin/bash TOTAL_SIZE=0 TARGET_DIR=/data/Nas_old LIMIT=2048 INTERVAL=120 find $TARGET_DIR -type f | while read FILE do SIZE=`wc -c "$FILE" | awk '{print $1}'` TOTAL_SIZE=`expr $TOTAL_SIZE + $SIZE` echo "Found $FILE" echo -e "\tFile size: $SIZE" echo -e "\tTOTAL: $TOTAL_SIZE" echo -e -n "\tTry to delete $FILE ... " ionice -c 3 rm -f "$FILE" >& /dev/null 2>&1 if [ $? -eq 0 ]; then echo "[SUCCESS]" else echo "[FAIL]" fi S=`expr $TOTAL_SIZE / 1048576` if [ $S -ge $LIMIT ]; then echo "TOTAL_SIZE is over than $LIMIT MB. Sleep $INTERVAL sec." sleep $INTERVAL TOTAL_SIZE=0 fi done

何も考えず10分ほどで書いたので保証はしません…

一応各ファイルのサイズを見て,2GB以上削除するごとに120秒スリープするようにしています.1ファイル当たりの容量が数十GBになっても120秒しかスリープしないので,大きなファイルがある場合もっと賢い処理をした方が良いかも知れません.

$ screen -r del

$ sudo ./delete.sh

何日かかかりましたがこれで全て削除出来ました.

最後にdestroyすれば完了です.

$ sudo zfs destroy data/Nas

ちゃんと完了しました.

まとめ

メモリ24GB程度でdedup=onにすることはもはや災害に等しいので皆さん絶対に辞めましょう.

脚注

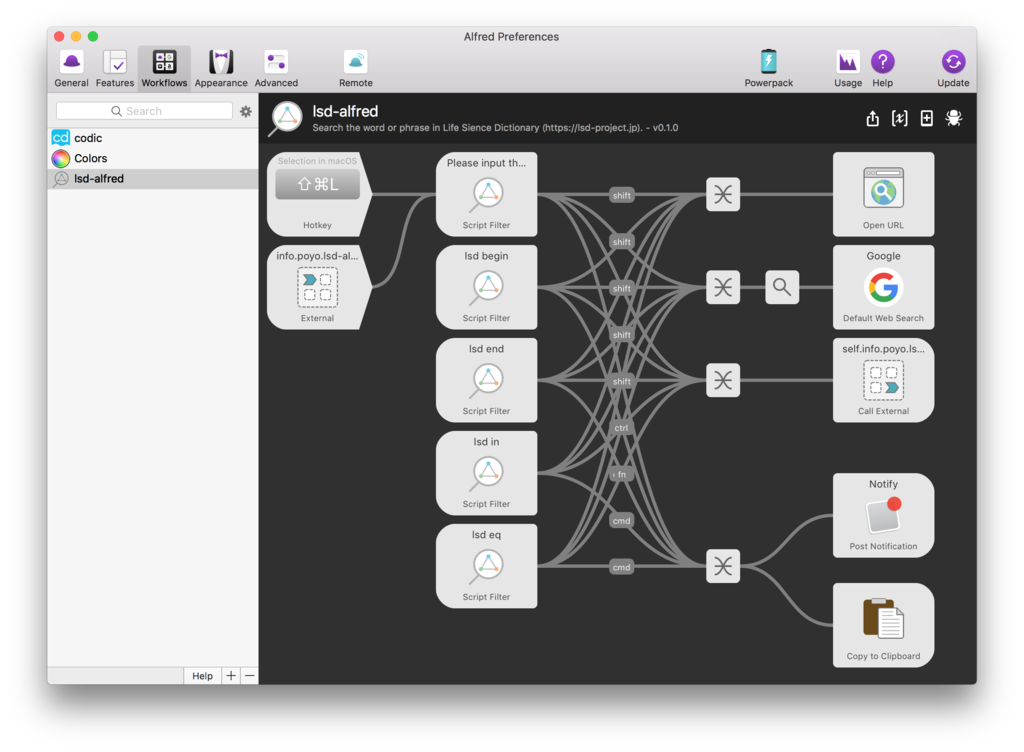

ライフサイエンス辞書で単語を引くAlfred Workflowを作った

きっかけ

生物学を学んでいる身としては論文を読んでるときとかにパパッとライフサイエンス辞書を引けたら嬉しいなと思ったのと,ただ単に検索結果のURLをブラウザで開くだけなら最初からブラウザ使えば良いよねと思ったので,自作してみることにしました.

Go言語を使ったわけ

ライフサイエンス辞書は通常開くウインドウとは別に,こういった検索方法も存在します.最初はこれをただURL開くだけで良いかとも思ったのですが味気なく,しかしJSONやXMLなどのAPIでもないためこれを再利用するにはスクレイピングが必須です.

AlfredのWorkflowでは様々なスクリプトを実行できますし,そのままターミナルを叩けるのですが,スクリプト言語の利用できるライブラリはその環境に依存してしまいます.スクレイピングをするのに外部ライブラリ無しという縛りはあまりにも鬼畜であるので,どうにかしてライブラリを使いつつ,環境依存を減らしたいなと考えたときにGoを思い出しました.

バイナリ一発で動くというのが魅力で,今回の用途に適しているのではないかと考えやったことも無いのにとりあえず書いてみることにしました.

環境

- Alfred v3.3.1

- Go 1.8.1

- Glide 0.12.3

今回はGoのパッケージ管理にGlideを使用しました.なお,このWorkflowを動作させるだけであればGoもGlideも必要ありません.自分でビルドする場合のみ導入してください.

lsd-alfred

リポジトリは以下になります.

できること

ライフサイエンス辞書から単語を引くことが出来ます.英語,日本語どちらでも検索可能です.

検索方法は以下の4通りあります.

- 前方一致:

lsd begin "{query}" - 後方一致:

lsd end "{query}" - 部分一致:

lsd in "{query}" - 完全一致:

lsd eq "{query}"

検索してブラウザで開く

検索した後Shift + Enterでデフォルトブラウザを使用して開きます.

検索してクリップボードにコピー

検索した後Command + Enterでクリップボードにコピーします.

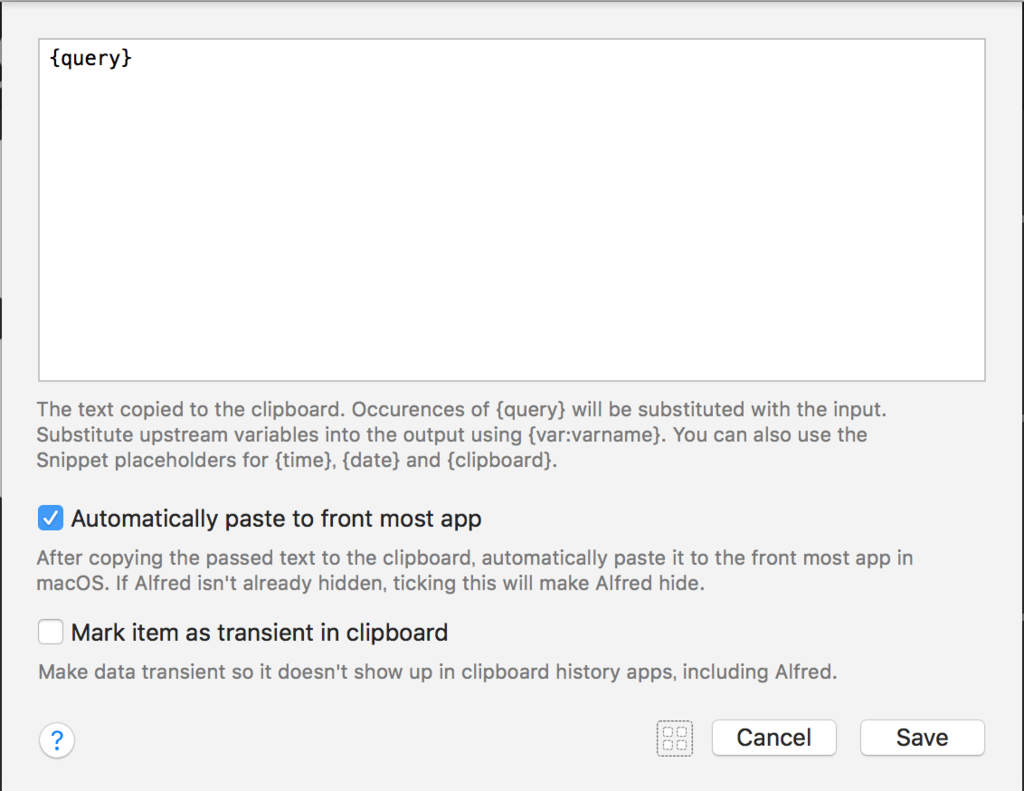

また,最前面の入力ウインドウに対して自動的に入力を行います.この設定はWorkflow中のCopy to Clipboard中のオプションを変更することで無効にもできます.

検索結果から再検索

検索した後Fn + Enterで再検索をかけます(意味があるのかは分からない…)

検索結果をさらに検索エンジンにかける

検索した後Ctrl + Enterでググります.

検索結果をSpotlight検索にかける

検索した後Alt + EnterでSpotlight検索にかけることができます.(GIF略)

検索結果の一覧ページを開く

See all resultsの項目でShift + Enterすると一覧が開きます.(GIF略)

ホットキーを使用して選択文字列を検索

初期では使用できません.使いたい場合,Alfred Workflowの設定を開いてlsd-alfredのHotKeyの項目に好きなキーを割り当ててください.デフォルトでは部分一致検索を行います.

できないこと

まだシソーラスとコーパス検索には対応していません.が,原理的には同様にスクレイピングをするだけで実現可能であるため,実装すれば実現は容易です.

まとめ

作ろうと思い至ってからGoに入門して完成までだいたい2日でここまできたので個人的には満足です.が,まだまだ常用ツールとしては未熟な作りでひどいコードなので少しずつリファクタリングしていきたい…たぶんバグたくさんあるのでPR待ってます(他力本願)

一応.alfredworkflowなパッケージは以下からダウンロードできます.使用は自己責任で…

Releases · pddg/go-lsd-alfred · GitHub

Alfred Workflowの作り方

ネットを検索していると何か色々とWorkflowの作り方が出てきますが大抵古いです.現在は標準でAlfred 3がエクスポートの機能を持っており,外部ツールを用いる必要はありません.

Alfred無しで(CI等で).alfredworkflowなパッケージを作るにはどうもzip圧縮して拡張子を変更してやれば良いだけ?っぽいです.

以下簡単に手順です.

- Blank Workflowを作成し,詳細情報を入力

- 作成したWorkflowを二本指タップすると

Open in Finder…が出てくるのでそれを押す - 開いた場所に実行するスクリプトや必要な設定ファイル等を置く

- 編集する

- Exportする

以上です.

Workflowとスクリプトの連携について

phpなどを使う場合,あらかじめ用意されたworkflow.phpなどを利用する方法が出てきますが,今回のように自作バイナリを叩く場合の記述に関しては全然見当たらなかったので本家の英語ドキュメントを軽く読んでやりました.今でも合っている自信が無いです.

Alfred 3からはXMLだけでなくJSONも使用できます.一応XMLは後方互換のために残しているだけのような感じなので,JSONを使用していこうと思います.Workflowで使用するのはScript Filterです.

{"items": [ { "uid": "ID", "type": "file|default|skipcheck", "title": "title", "subtitle": "subtitle", "arg": "url", "autocomplete": "title", "valid": true "icon": { "type": "fileicon", "path": "path" }, "mods": { "alt": { "valid": true, "arg": "url", "subtitle": "subtitle" } }, "text": { "copy": "Text to copy", "largetype": "Large Text" }, "quicklookurl": "url" } ]}

uid: ユニークキー.ここの値を元にソートされるっぽい.type: このオブジェクトがファイルなのか,それ以外なのかを示す.fileを指定すると存在するかのチェックが入るので嫌な場合はskipcheckにせよと書いてある.arg: 表示されたオブジェクトを選択してEnterを押したとき,次に渡される値.URLなど.icon:typeもpathも空欄にしておくとパッケージに含めたicon.pngが勝手に使用される.valid: Enter押したときに次のアクションを行うかどうかmods: 修飾キーと組み合わせたとき,次に渡す値を変化させることが出来る.例えばalt+Enterのときはタイトルを出力するが,Cmd+EnterのときはURLを出力すると言った挙動に出来る.使える修飾キーはCmd,Alt,Ctrl,Shift,Fntext:copyの値はコピーしたときクリップボードにコピーされる値.largetypeはCmd+Lを押したときに表示されるLargeTypeに表示するテキスト.

最終的に上記の形式(全てを含めなくても良い)のJSONを標準出力にPrintするだけで簡単に使えます.最高.

まとめ

Goは言語自体はシンプルなのですが,どうにもエラー処理やスライスの周りで頭が混乱してしまいます.もう少し使えるようになればかなり便利そう…

Alfred 3,Workflowでできることがとても多くて重宝しています.課金して良かった.